Gezichtsherkenning: welke juridische en ethische aspecten brengt het met zich mee?

- Techblog

Van een groot aantal collecties is er vandaag nauwelijks beschrijvende metadata voorhanden. Dit beperkt niet alleen de vind- en doorzoekbaarheid van deze collecties, maar ook het (her)gebruik ervan. Gezien handmatige metadatacreatie een erg tijdrovende klus is, onderzoeken we in twee projecten de mogelijkheden van artificiële intelligentie bij automatische metadatacreatie. Met dergelijke technologieën moet echter op een voorzichtige manier omgesprongen worden. Daarom gaan we in deze techblog dieper in op juridische en ethische uitdagingen.

De twee projecten in vogelvlucht

Juridisch versus ethisch

Wanneer we een technologie als gezichtsherkenning willen inzetten om cultureel erfgoed te metadateren, moeten we voldoende stilstaan bij de juridische en ethische context waarin dat gebeurt. Technologie is namelijk niet neutraal of onschuldig. Ze kan binnen een correct juridisch en ethisch kader nobele doelen dienen, maar binnen andere contexten ook de rechten en vrijheden van burgers beknotten of in gevaar brengen. Denk aan kernenergie of het gebruik van drones, maar ook aan artificiële intelligentie (AI).

Wat verstaan we dan precies onder ‘het juridische’ en ‘het ethische’? Ethiek gaat over de morele principes die ons gedrag en onze handelingen sturen. ‘Het juridische’ slaat op alles wat een relatie heeft met het recht. Morele of ethische principes liggen regelmatig aan de basis van wetgeving, maar ethiek gaat toch een stuk verder dan wat er in wetteksten vervat zit. Bij het toepassen van gezichtsherkenning bouwen we daarom niet alleen de nodige juridische waarborgen in, maar maken we ook ethische afwegingen.

Juridische vraagstukken

Met technologieën als gezichtsherkenning springen we in onze werking op een voorzichtige manier om. Bovendien is er een wettelijke verplichting om op een verantwoorde manier met de persoonsgegevens van afgebeelde personen om te gaan. Hier houden we rekening mee in het FAME-project, onder meer door gespecialiseerde juridische begeleiding. Ook binnen het GIVE-metadataproject is er specifieke juridische begeleiding zodat we privacy en een goed juridisch kader niet uit het oog verliezen.

FAME: auteursrecht, recht op afbeelding en GDPR

1. Auteursrecht

In het FAME-project was het zaak om drie juridische aspecten in het achterhoofd te houden. Ten eerste werken we met foto’s die auteursrechtelijk beschermd zijn. Dit betekent dat we het fotomateriaal enkel kunnen gebruiken binnen de wettelijk bepaalde uitzonderingen, of met de toestemming van de rechthebbenden. Het doel van het project is niet om auteursrechtelijk materiaal te publiceren, wel om aan de hand van referentiemateriaal algoritmes te trainen en te verbeteren, en op die manier de gedefinieerde fotosets te metadateren. Daarvoor kunnen we ons beroepen op de onderwijs- en onderzoeksexceptie.

Waarom kunnen we ons hierop beroepen? De nadruk in FAME ligt op het ontwikkelen van best practices om personen op foto’s en in video’s te identificeren via (semi-)geautomatiseerde gezichtsherkenning, en ten tweede op het onderzoeken hoe we bestaande metadata kunnen gebruiken om de accuraatheid van de gezichtsherkenning te verbeteren. Bovendien doen we dit in nauwe samenwerking met een erkende onderzoeksinstelling, namelijk onze technische partner IDlab van UGent.

2. Recht op afbeelding

Daarnaast bezitten natuurlijke personen in België een recht op afbeelding. Dit wil zeggen dat ze toelating moeten geven voor het maken en gebruiken van hun eigen beeltenis, en ook voor iedere reproductie en publicatie van die foto(’s). Voor publieke personen wordt deze toestemming vermoed, op voorwaarde dat de afbeeldingen gemaakt werden tijdens de uitoefening van hun publieke activiteit. Deze uitzondering is van groot belang in het FAME-project. Met dit in gedachten kozen we de datasets voor dit project. Toch moeten we bewaken dat alle afgebeelde personen (denk aan eenmalige acteurs, toeschouwers van wielerwedstrijden, publieke personen in een niet-publieke setting…) wel degelijk een publieke activiteit uitoefenen.

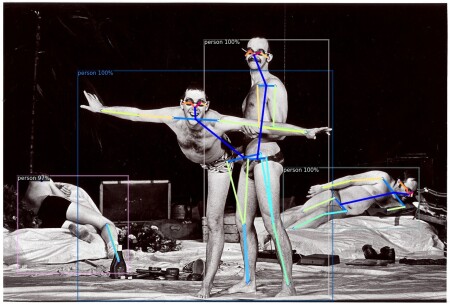

In beeld: Dirk Pauwels en Josse De Pauw in ‘Ik wist niet dat Engeland zo mooi was’ van theatergezelschap Radeis, foto door Michiel Hendryckx, CC BY-SA 4.0

3. GDPR

Als laatste moeten we rekening houden met de Algemene Verordening Gegevensbescherming (AVG of GDPR). Deze beschouwt het maken, opslaan en gebruiken van foto’s waarop personen staan afgebeeld als een verwerking van (persoons)gegevens, die bijgevolg strikt gereglementeerd is. De verwerking van deze ‘biometrische’ gegevens met het oog op identificatie is in principe verboden wanneer je geen beroep kan doen op een uitzondering. Als organisatie met een decretale opdracht beroept meemoo zich op volgende verwerkingsgrond: “de verwerking is noodzakelijk voor de vervulling van een taak van algemeen belang of van een taak in het kader van de uitoefening van het openbaar gezag dat aan de verwerkingsverantwoordelijke is opgedragen.” (AVG art. 6.1.e).

Bovendien kan meemoo een beroep doen op een versoepeld regime dat de AVG inbouwt, specifiek voor verwerkingen met het oog op archivering in het algemeen belang, wetenschappelijk of historisch onderzoek of statistische doeleinden (AVG art. 89.1-3). De regelgeving stelt wel dat het belangrijk is dat de balans met de privacy en rechten van de betrokkenen goed wordt bewaakt, en dat er de nodige waarborgen zijn op technisch en organisatorisch vlak.

GIVE: juridische omkadering

In het GIVE-metadataproject werd al in de voorbereidende fase van het project een belangrijke stap gezet om te voldoen aan de regelgeving met betrekking tot de bescherming van persoonsgegevens: de uitvoering van een DPIA (Data Protection Impact Assessment of gegevensbeschermsingseffectbeoordeling in het Nederlands). Hieronder doen we uitvoerig uit de doeken wat dit inhoudt en hoe we te werk zijn gegaan.

1. Schetsing van de context

Eén van de rode draden doorheen de AVG is de zogenaamde ‘verantwoordingsplicht’. De AVG legt de verantwoordelijkheid bij organisaties om aan te tonen dat zij aan de privacyregels voldoen. Dit houdt in dat een organisatie als verwerkingsverantwoordelijke moet analyseren en inschatten wat de risico's zijn van een bepaalde verwerking, en hoe deze risico's zo veel mogelijk te beperken zodat de bescherming van de rechten en vrijheden van de betrokkenen en van zijn persoonsgegevens gewaarborgd blijven.

Voor een geplande verwerking die waarschijnlijk een hoog risico inhoudt voor de rechten en vrijheden van natuurlijke personen, en in het bijzonder wanneer nieuwe technologieën worden gebruikt, moet een verwerkingsverantwoordelijke zelfs vóór de verwerking een beoordeling uitvoeren van het effect van de beoogde verwerkingsactiviteiten op de bescherming van persoonsgegevens. Deze beoordeling wordt in de AVG een ‘gegevensbeschermingseffectbeoordeling’ genoemd. Een hele mond vol, daarom wordt doorgaans de Engelse afkorting ‘DPIA’ (Data Protection Impact Assessment) gebruikt.

In beeld: Minister Nijpels overhandigt Kamervoorzitter Dolman grote sleutel, foto door Rob Croes, Anefo, CC0

2. Hoe ging het in zijn werk?

In nauw overleg met de Data Protection Officer (DPO) voerde meemoo een DPIA uit in de voorbereidende fase van het GIVE-metadataproject. In een eerste fase maakten we een algemene beschrijving van de beoogde verwerking. Hiervoor maakten we een overzicht van de types persoonsgegevens die we plannen te verwerken, het doel van de verwerking, de bronnen van de te verwerken persoonsgegevens, de betrokkenen…

Dit overzicht liet ons toe om over te gaan tot een tweede analyse waarbij we voor elke verwerkingsactiviteit het mogelijke risico konden identificeren. Voor elk risico werd bekeken welk schadetype zich kon voordoen, hoe groot de kans is, en wat de ernst van de impact zou zijn. Op basis van deze variabelen kwamen we, gebaseerd op een risicomatrix, tot een totaalrisico.

Vervolgens gaven meemoo-collega’s uit verschillende teams en met verschillende achtergronden input over de maatregelen die we konden nemen om dat totaalrisico zo klein mogelijk te maken. Per verwerkingsactiviteit kwamen we tot organisatorische, technische en juridische maatregelen.

Een voorbeeld van zo’n verwerkingsactiviteit is het sturen van een beperkte set data naar verschillende kandidaat-leveranciers die erfgoedcollecties kunnen voorzien van metadata o.b.v. machine learning. Zo kunnen zij deze testset metadateren, en kan meemoo aan de hand van de resultaten nadien de gebruikte technieken evalueren.

Het risico wordt voor deze verwerkingsactiviteit beperkt door het volume van de testset klein te houden, en die testset zodanig samen te stellen dat deze geen content met gevoelige persoonsgegevens bevat. Tijdens transmissie wordt de data versleuteld, door gebruik te maken van geëncrypteerde transmissie (sFTP, HTTPs). Meemoo gebruikt servers en diensten die up-to-date zijn, waardoor technische risico's verder verkleind worden. Daarnaast hebben we uitvoerige bepalingen gemaakt m.b.t. de verwerking van persoonsgegevens, die we opleggen in het bestek, en die (een deel van) de verwerkersovereenkomst zullen vormen. Hierin is onder andere bepaald dat alle bestanden na verwerking verwijderd worden door de kandidaat-leveranciers. Ten slotte zullen we ook NDA’s sluiten met alle betrokken verwerkers.

Door alle activiteiten zo af te lopen bleven er slechts enkele restrisico’s over. Deze restrisico’s werden beschreven, maar waren dermate klein dat na een belangenafweging geoordeeld werd dat deze aanvaard kunnen worden.

3. Conclusie?

Deze procedure liet ons toe om in de voorbereidende fase van het GIVE-metadataproject zowel de risico's in te schatten, als de manier waarop deze kunnen worden beheerd. In het verdere verloop van het project zullen we de organisatorische, technische en juridische maatregelen die we bedachten effectief implementeren. De DPIA geldt hierbij als kader en leidraad.

Ethische vraagstukken

Naast juridische correctheid is het belangrijk dat we zorgen voor een ethisch verantwoorde toepassing van artificiële intelligentie in de cultureelerfgoedsector. Omdat het gezichtsherkenningsluik van het GIVE-metadataproject momenteel nog in de kinderschoenen staan, zoomen we in deze techblog in op enkele ethische uitdagingen uit het FAME-project. GIVE neemt uiteraard de bezorgdheden en aandachtspunten die binnen FAME gebeurden mee in het metadataproject.

Hoe stellen we referentiesets samen?

De toepassing van gezichtsherkenningstechnologie vereist goede referentiesets. Dat zijn verzamelingen foto’s waarvan we zeker zijn dat ze een bepaalde persoon afbeelden. Een algoritme zal die referentiefoto’s vergelijken met de foto’s uit de doelcollecties en voorspellen met welke waarschijnlijkheid de afgebeelde personen daar ook in voorkomen. Maar hoe ethisch is het massaal verzamelen en bewaren van foto’s op het web zonder toestemming van afgebeelde personen? En valt het te verantwoorden dat we deze sets buiten de huidige projecten delen?

In beeld: Wielrenner Piet de Wit gehuwd, foto door Bert Verhoeff, collectie Anefo, CC0

Hoe we hiermee omgaan?

We kiezen enkel voor publieke figuren in de creatie van referentiesets. Dit verkleint het aantal juridische en ethische obstakels, en beperkt de impact op privépersonen. Bij het gebruiken van open content voor AI is ons standpunt: we moeten zowel naar het uiteindelijke doel (wat we met de foto’s doen) als naar de eventuele negatieve gevolgen voor de afgebeelde personen kijken om te bepalen of het massaal verzamelen van foto’s voor gezichtsherkenning ethisch verantwoord is.

En de volgende vraag: kunnen we deze referentiesets delen buiten het project? Zeker binnen de Vlaamse cultureelerfgoedcontext is er een potentiële efficiëntiewinst verbonden aan het delen en hergebruiken van referentiesets. Zo kunnen de instellingen het tijds- en arbeidsintensieve proces van het samenstellen van referentiesets rationaliseren. Het delen van foto’s impliceert echter ook een controleverlies. Het blijft een vraagstuk hoe we dit evenwicht kunnen behouden. Wel zien we wereldwijd een trend om het gebruik van AI te reguleren, al blijft naast deze regelgevende kaders beroepsethiek essentieel. De maatschappelijke missie en het waardenkader van cultureelerfgoedorganisaties kunnen die beroepsethiek vormgeven.

Vooringenomenheid (bias) in algoritmes

Een andere uitdaging die zich bij AI-toepassingen stelt, is dat het gebruik van algoritmes kan resulteren in vooringenomenheid, oftewel bias. Binnen gezichtsherkenningstoepassingen komen vooral raciale en genderbiases voor. Het gevaar is dat bestaande maatschappelijke ongelijkheden bevestigd of vergroot worden. Het is dus van belang om bias waar mogelijk te voorkomen. Wanneer dat niet (volledig) mogelijk is, moeten zowel de gevolgen beperkt worden als de potentiële biases maximaal zichtbaar worden gemaakt.

Hoe we hiermee omgaan?

In FAME worden biases deels voorkomen door in ieder pilootproject zorgvuldig gecreëerde referentiedatasets te gebruiken. Toch is dit niet sluitend. Bias kan namelijk al optreden in de fase waarin software mensen op foto’s detecteert. Op foto's een mens van 'niet-mensen' onderscheiden, impliceert een bepaalde normering. Die is noodzakelijk om zinvolle categorieën te creëren en zo valse positieven en negatieven te vermijden. De karakterisering van het concept ‘mens’ bepaalt niet enkel of er niet te veel ‘niet-mensen’ als ‘mens’ worden gecategoriseerd, maar ook of alle mensen even goed herkend worden, ongeacht hun fysieke eigenschappen of kledij.

In het FAME-project controleerden we het gebruikte algoritme op bias aan de hand van een manuele steekproef. De resultaten van die steekproef zijn op het eerste gezicht geruststellend. Zo bleken hoofddeksels, een zonnebril, een hoofdtelefoon en zelfs een mondmasker geen probleem voor automatische gezichtsdetectie.

Automatisering als bedreiging voor jobs

Een veelgehoorde kritiek op nieuwe technologieën, en zeker artificiële intelligentie, is dat ze een bedreiging vormen voor jobs van mensen. Alhoewel menselijk en begrijpelijk, is deze vrees niet echt gefundeerd. Onderzoek toont namelijk aan dat technologische evoluties ertoe leiden dat bepaalde jobs verdwijnen, maar dat er evengoed andere jobs bijkomen. Wel veranderen de jobs door de toegenomen automatisering. Hierbij zijn laaggeschoolden het kwetsbaarst, omdat zij vaak repetitieve taken uitvoeren.

In beeld: Women in industry, tool production, 1942, Ann Rosener, publiek domein

Hoe we hiermee omgaan?

Binnen FAME richten we ons op de automatisering van werk dat vandaag wegens tijdgebrek en personeelstekort niet gebeurt. Dit betekent niet dat machines mensen vervangen. Mensen denken en redeneren, machines maken berekeningen waarvoor ze geprogrammeerd zijn. De samenwerking tussen mens en algoritme blijft cruciaal, en de rol van de mens achter de machine wordt in zekere zin zelfs belangrijker dan voordien.

Werkomstandigheden van data labellers

Algoritmes trainen met grote hoeveelheden data vraagt veel mankracht. Wie dit werk van data labelling uitvoert en in welke omstandigheden, varieert. Soms gaat het om correct betaalde vaste werknemers, soms om stagiairs of vrijwilligers. Anderen doen beroep op crowdsourcing of op ‘ghost workers’ of ‘click workers’ in lageloonlanden met barre arbeidsomstandigheden. Binnen FAME gebruiken we enkel voor het onderdeel van gezichtsdetectie eerder ontwikkelde software. We weten wel wie de door ons gebruikte toolbox Insightface heeft ontwikkeld, maar niet met welk doel en in welke omstandigheden dat is gebeurd. Ook hoe cultureelerfgoedorganisaties de manuele validatie van de matchingresultaten aanpakken, blijft een ethisch aandachtspunt.

Impact op het milieu

Gezichtsdetectie en -herkenning zijn processen die veel rekenkracht en energie vragen. Niet alleen het gebruik, maar ook de ontwikkeling van de software die eraan voorafgaat, vereist veel energievretende training. Een substantieel deel van die energie komt niet uit hernieuwbare bronnen. Zoals bij alle ethische kwesties die hierboven aan bod kwamen, zijn zowel het terugdringen van nefaste effecten (bv. door energie-efficiëntere workflows en algoritmes) als transparantie belangrijke aandachtspunten.

Wat nemen we mee uit deze vijf ethische vraagstukken? Het Montreal AI Ethics Institute haalt de vier ‘kardinale deugden’ van Ambrosius van Milaan vanonder het stof als een verrassend geschikte leidraad voor ethische AI-toepassingen:

Prudentia - voorzichtigheid, verstandigheid, wijsheid

Iustitia - rechtvaardigheid, rechtschapenheid

Fortitudo - moed, doorzetting

Temperantia - gematigdheid, zelfbeheersing

Het voorkomen van ongewenste uitkomsten blijft noodzakelijk, maar de grootste garantie op een ethische omgang met artificiële intelligentie blijft wellicht dat iedereen die betrokken is bij een AI-project dat vanuit de vier bovenstaande deugden doet. Zo komt de focus te liggen op het gedrag van mensen. En dat gaat verder dan het juridische kader. Bovendien - zo heeft de geschiedenis reeds bewezen - bezitten deze deugden een tijdloosheid die razendsnelle technologische evoluties doorstaat.